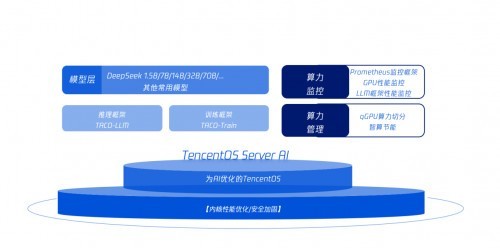

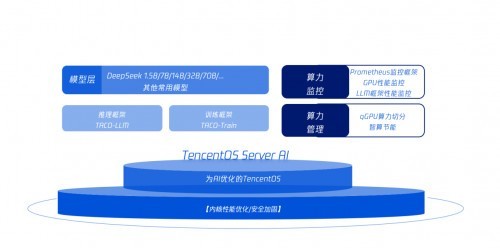

随着生成式AI技术的爆发式增长,AI大模型开始渗透至手机领域,一线厂商已经把AI应用集成到各自最新的产品中,并且在以惊人的速度迭代。为了进一步提升大模型部署的效能,荣耀基于应用腾讯云TencentOS Server AI中提供的TACO-LLM加速模块部署DeepSeek-R1等开源大模型,并应用荣耀企业内部等场景,稳定性、可靠性、推理性能均大幅提升。

在推理平台场景中,荣耀侧重关注框架效能、稳定性、运行状态监控及应急预案等特性。使用TACO-LLM进行推理任务后,在DeepSeek-R1 满血版场景下,相对于荣耀原始线上业务性能,TTFT(首Token 延迟)P95 的响应时间最高降低6.25倍,吞吐提升2倍,端到端延迟降低100%。在社区最新版本sglang场景下,TTFT P95的响应时间最高降低12.5倍。

腾讯云TACO-LLM之所以能够对荣耀业务的性能提升如此明显,主要的得益于多种投机采样技术核心能力:大语言模型的自回归解码属性无法充分利用GPU的算力,计算效率不高,解码成本高昂。而TACO-LLM通过投机采样的方式,从根本上解决了计算密度的问题,让真正部署的大模型实现“并行”解码,从而大幅提高解码效率。

荣耀大数据平台部相关负责人表示:“荣耀使用腾讯云 TACO-LLM 打造高性能的AI底座,部署稳定可靠,提升了性能加速体验。”

TencentOS Server AI加速版中提供的TACO-LLM加速模块,针对企业级AI模型私有化部署挑战,对大语言模型业务进行了专门的内核运行优化,用于提高大语言模型的推理效能,提供兼顾高吞吐和低延时的优化方案,能够“无缝”整合到现有的大模型部署方案中。

本文属于原创文章,如若转载,请注明来源:腾讯云TencentOS Server AI,助力荣耀打造高性能AI底座https://news.zol.com.cn/994/9945392.html