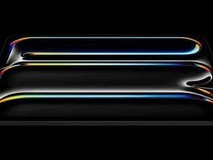

在2023年全球超算大会(SC2023)上,芯片巨头英伟达发布了其最强AI芯片H200的继任者。这款芯片基于英伟达的Hopper架构,性能直接提升了60%到90%,并且与H100可以互相兼容。

H200是英伟达首款使用HBM3e内存的芯片,具有更快的速度和更大的容量。它适合用于大语言模型的训练或推理,并且内存容量为141GB,带宽增加了50%。主要体现在大模型推理表现上,H200在700亿参数的Llama2大模型上的推理速度比H100快了一倍,并且在推理能耗方面降低了50%。

对于显存密集型HPC应用来说,H200更高的显存带宽能够确保高效地访问操作数据。与CPU相比,在获得结果的时间最多可提升110倍。

据称,英伟达预计将于2024年第二季度出货H200芯片。然而售价尚未公布,但考虑到当前算力短缺的情况下,大科技公司可能会疯狂购买这款产品。

本文属于原创文章,如若转载,请注明来源:英伟达发布全球最强AI芯片H200:性能较H100提升近一倍https://news.zol.com.cn/842/8420095.html