随着AI技术的快速发展,AI已从过去的感知AI、生成式AI,快速迈入AgenticAI 时代。AI正在进化出端到端的自主决策和执行能力,走向核心生产环节。

火山引擎总裁谭待

今天,在FORCELINK AI创新巡展·杭州站,火山引擎公布了模型、Agent工具、云基础设施的最新进展,旨在帮助企业更快、更省地构建和部署Agent应用:发布豆包1.5·深度思考模型,升级豆包·文生图模型3.0、豆包·视觉理解模型。同时,面向Agent服务,发布OSAgent解决方案、GUIAgent大模型——豆包1.5·UI-TARS模型;面向大规模推理,发布AI云原生·ServingKit推理套件。

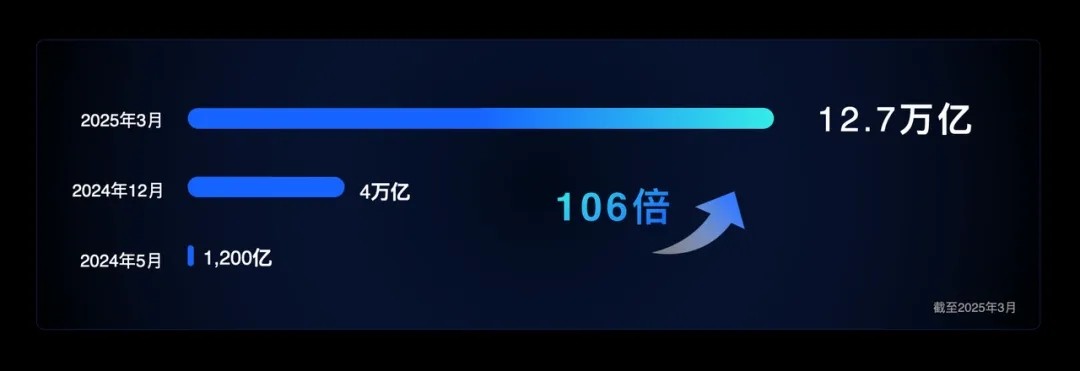

截至2025年3月底,豆包大模型日均tokens调用量已超过12.7万亿,是2024年12月的3倍,是一年前刚刚发布时的106倍。IDC报告显示,2024年中国公有云大模型调用量激增,火山引擎以46.4%的市场份额位居中国市场第一。

深度思考模型能够让AI模拟人类的思维过程,对复杂问题进行精准分析和逻辑推导。

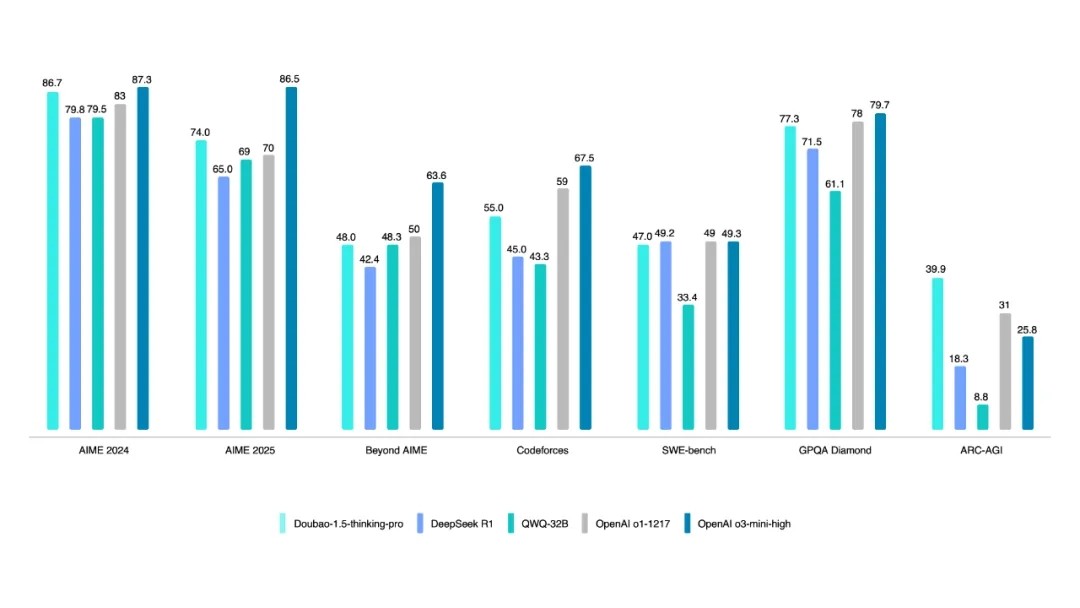

全新发布的豆包1.5·深度思考模型,在数学、代码、科学等专业领域推理任务中表现出色,已经达到或接近全球第一梯队水平;在创意写作等非推理任务中,模型也展示出优秀的泛化能力,能够胜任更广泛和复杂的使用场景。

为了提升模型的通用能力,模型团队优化了数据处理策略,把可验证数据与创意性数据进行融合处理,满足各类任务的需求。此外,大规模强化学习是训练推理模型的关键技术,通过采用创新的双轨奖励机制,兼顾“对错分明”和“见仁见智”的任务,有效实现了算法的可靠优化。

豆包1.5·深度思考模型采用MoE架构,总参数为200B,激活参数仅20B,具备显著的训练和推理成本优势。基于高效算法,豆包1.5·深度思考模型在提供行业极高并发承载能力的同时,实现20毫秒极低延迟。

在解决生活生产中的具体问题时,大模型要能够查询互联网信息,进行多轮搜索和思考。与其他推理模型“先搜索再思考”的模式不同,豆包APP基于豆包1.5·深度思考模型进行了定向训练,可以“边想边搜”。

例如,让豆包APP推荐露营装备:一对夫妻带两个孩子去露营,温度低,有雨,希望把装备买齐,预算4,000元以内,还要兼顾便携性和安全性。豆包1.5·深度思考模型可以拆解每个具体需求的注意事项,规划信息,然后经过3轮搜索,给出了预算范围内、细致周到的推荐。

此外,豆包1.5·深度思考模型还具备视觉理解能力,可以像人类一样,不光基于文字思考,更能基于所见画面思考,思考更立体,让模型同时拥有“大脑”和“眼睛”。 更好的模型性能、更低的延迟、加上视觉推理能力,将为深度思考模型打开更广泛的应用空间、解决更复杂的问题。即日起,企业用户可以在火山方舟平台使用豆包1.5·深度思考模型。

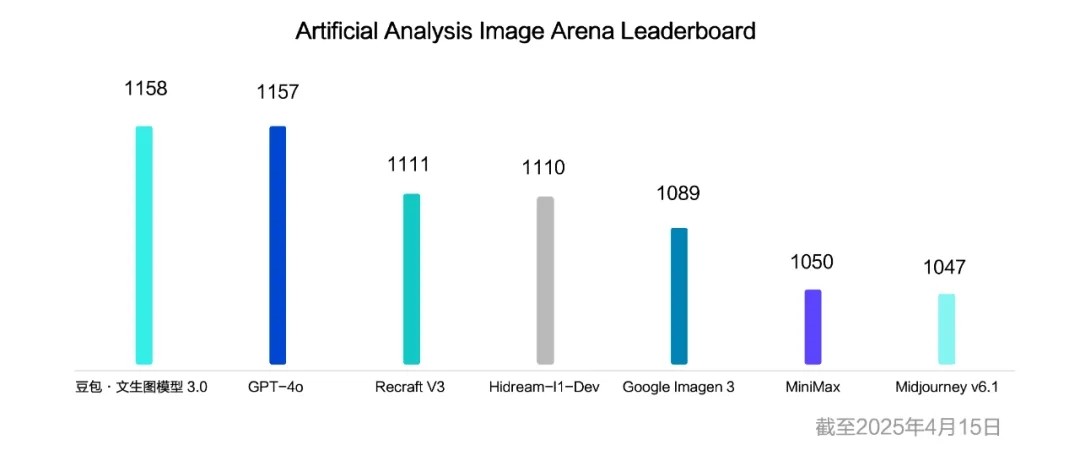

此次全新升级的豆包·文生图模型3.0,能够实现更好的文字排版表现、实拍级的图像生成效果,以及2K的高清图片生成方式。可以广泛应用于影视、海报、绘画、玩偶设计等营销、电商、设计场景。

小字与长文本生成、排版更美观

在最新的文生图领域权威榜单ArtificialAnalysis 竞技场中,豆包·文生图3.0模型已超越业界诸多主流模型,排名全球第一梯队。

新版本的豆包·视觉理解模型具备更强的视觉定位能力,支持多目标、小目标、通用目标的框定位和点定位,并支持定位计数、描述定位内容、3D定位。可应用于线下门店的巡检场景、GUIagent、机器人训练、自动驾驶训练等。 同时,新版本在视频理解能力上也有大幅提升,比如记忆、总结理解、速度感知、长视频理解等。豆包·视觉理解模型结合向量搜索,可直接对视频进行语义搜索,广泛适用于安防、家庭看护等商业化场景。

更强的模型为我们打开了更广阔的应用空间。未来,AIAgent 将同时在“应用Agent”和“OSAgent”两个方向上并行发展。

应用Agent具备更强的专业性,如客服Agent、数据Agent、代码Agent等,可以专注于完成特定领域的任务。

比如在代码Agent领域,相比于传统的AI插件产品,国内首个AIIDE(AI原生的集成开发环境工具)——Trae可以让开发者和AI更智能的协作,实现软件开发的交付化(交付软件而不仅是代码)、智能化(意图理解-自主规划-调用工具-自主开发)、协作化(与用户在各个维度上进行协作)。

OSAgent 则拥有跨场景的通用性和灵活性,能够直接操作浏览器、电脑、手机或其他Agent,完成复杂任务。今年Manus等通用Agent的火爆也点燃了市场对OSAgent 的热情。

大会上,火山引擎正式发布OSAgent 解决方案,未来两周将陆续上线火山引擎官网。

该解决方案通过火山引擎veFaaS平台对豆包大模型能力进行封装,可以让企业和开发者轻松构建轻量级的Codeuse 和Browseruse。而针对任务相对复杂的ComputerUse 和MobileUse Agent,则可以通过ECS或云手机等调用豆包1.5·UI-TARS模型,驱动图形用户界面交互,精准识别用户的任务需求,进行感知、自主推理并准确行动。

想做出好的Agent同样离不开好的大模型。针对复杂的OSAgent,火山引擎正式发布GUIAgent 大模型——豆包1.5·UI-TARS模型。该模型将屏幕视觉理解、逻辑推理、界面元素定位和操作整合在单一模型中,突破了传统自动化工具依赖预设规则的局限。目前,豆包1.5·UI-TARS模型已在火山方舟平台上线。

好的模型和工具能够加速Agent的落地,但Agent也会带来更大量的推理消耗,因此AI时代需要更好的云原生架构来支持。

为此,火山引擎推出ServingKit推理套件,帮助企业实现模型的快速部署、推理优化、运维可观测。

ServingKit推理套件可在2分钟内完成671BDeepSeek R1下载和预热,13秒完成推理引擎的加载。

同时,为了降低推理过程中的时延、提高资源利用率,火山引擎EIC将 KVcache 命中率提高了10倍,在100%cache 命中场景下 TPS吞吐量可提高至5倍以上;而通过对算子、AI网关、VKE编排调度的优化和升级,可以大幅度降低GPU消耗。